2016.06.27

データサイエンティスト養成講座 第3回受講レポート

6月8日、第3回目のデータサイエンティスト養成講座が開催されました。渋谷の交差点を渡り、センター街を若者や観光客の人の波をかき分けながら進んだ先にある、とあるビルの一室で養成講座は行われています。

第3回目の講義は「過学習と精度検証法」と「ロジスティック回帰」について。

まずは過学習(Over fitting)とは何か、そして過学習させないための方法を紹介します。

モデルを構築した時のデータでは予測精度が良いのに、モデル構築に使用していないデータ(未知データ)の予測精度が悪く、2つの予測精度の乖離が大きい時に、予測モデルは「過学習(過剰適合)」している、といいます。学習に使用する変数が多かったり、階層の数を増やし過ぎたり、終端ノード数を少なくしすぎたりすると、過学習が起きやすくなります。

では、過学習にならずに未知のデータに対するモデルの精度を上げるにはどうすればよいのでしょうか?複雑すぎず、過剰適合を起さないような最適なモデルを推定すればよいのです。

いくつかある方法の中で、本講義では

・ホールドアウト法(Hold Out法)

・クロスバリデーション法(Cross Validation法)

が紹介されました。

ホールドアウト法では、既に答えが分かっているデータを任意の割合で2つに分け「モデル構築データ」と「モデル検証データ」とすることによって、未知データに対する予測精度を推し量ることができます。ただし、これは十分なデータ量がある場合にのみ有効な手法です。クロスバリデーション法も同様に答えが分かっているデータを使用しますが、こちらはデータをK個に分割し、そのうち一つを「モデル検証データ」、残りのK-1個を「モデル構築データ」として、それをK回構築することによって未知データの予測精度を推し量ります。

続いて、ロジスティック回帰の解説。ツリーとは何が違うのでしょうか?

ロジスティック回帰は線形化モデルの一種で、2値問題(0,1の確率予測)に対して確率を返すように数式が工夫されています。また、ツリーでは最終カテゴリが何個かに分かれるので出力が飛び飛びになり逆転してしまうこともあるのに対し、ロジスティック回帰は連続性(線形)であり逆転が起きません。一方で、限定的に逆の挙動を示す表現はツリーではできるがロジスティック回帰では難しいという違いがあります。

そして注意点として、ロジスティック回帰モデルを構築する際には多重共線性(相関が高い説明変数を入れた場合にパラメータの推定がうまくいかない)や応答が非線形な変数・外れ値のような非線形な分布には気を付けなくてはならない、ということが挙げられました。

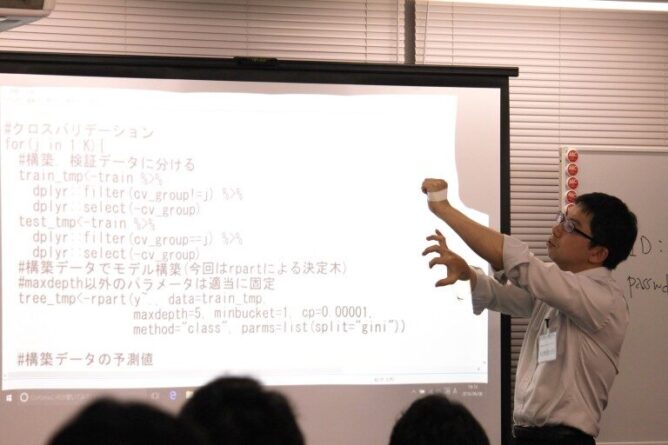

最後にいつものように演習が行われました。今回学んだ手法を用いて、モデルを構築していきます。演習中には講師に質問したり、グループ内で教え合ったりと、データサイエンティスト養成講座はだんだん活気付いてきたようです。

第4回の受講レポートはこちら

- カテゴリ

-

-

DS関連NEWS

-

インタビュー

-

スキルアップ

-

コラム

-

教えて!DS

-

- アーカイブ

-

-

2025年

-

2024年

-

2023年

-

2022年

-

2021年

-

2020年

-

2019年

-

2018年

-

2017年

-

2016年

-

- 記事アクセスランキング

-

- タグ